服务器使用https://www.etzyweb.cn/966.html

1.客户端安装

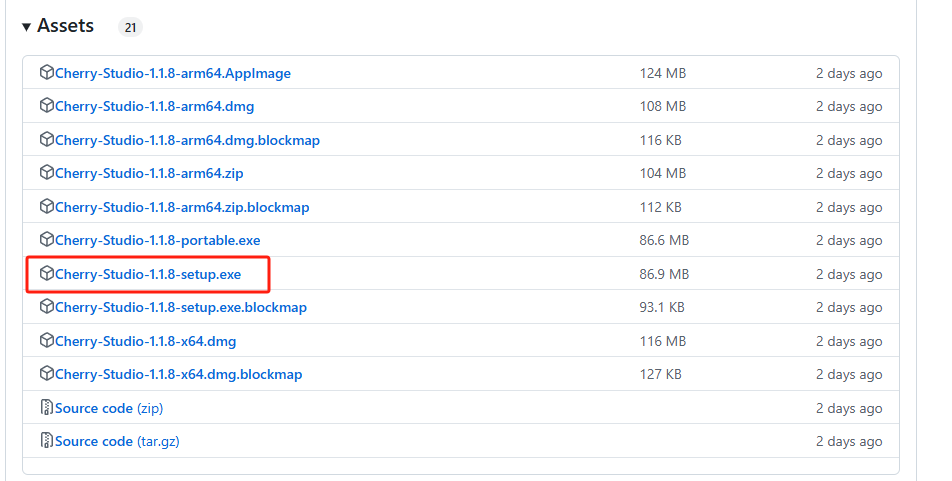

首先,我们需要访问Cherry Studio的github主页下载Windows版本客户端:

下载地址:https://github.com/CherryHQ/cherry-studio/releases

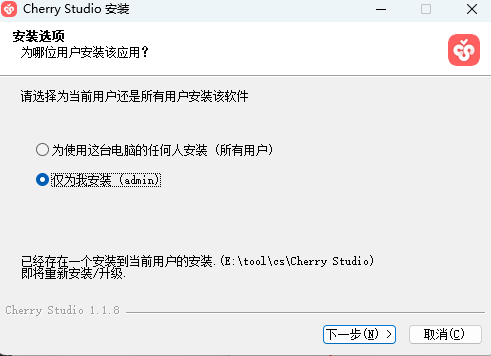

选择好安装位置后,即可快速安装:

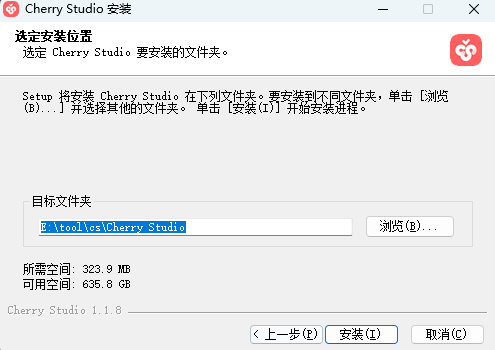

安装后打开Cherry Studio客户端,可以看到界面非常简洁明了。

本例中使用的版本号为:V1.1.8

-

MCP服务器配置

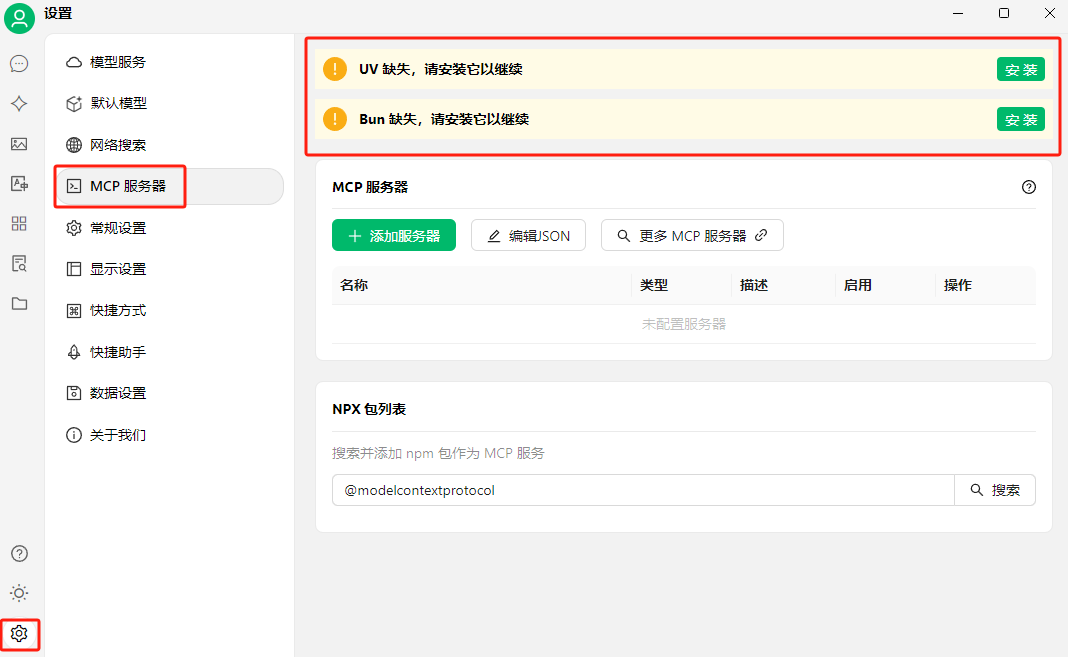

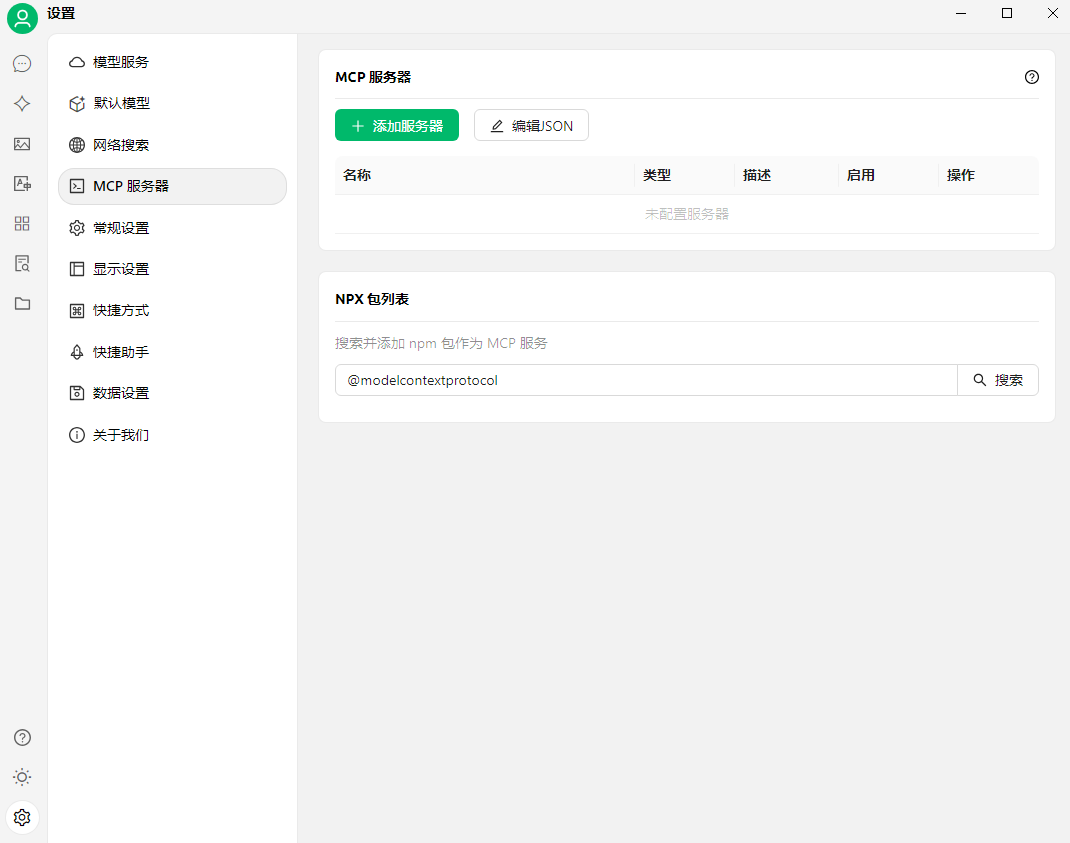

重启打开客户端后,点击设置-MCP服务器,可以看到需要安装UV与Bun环境:

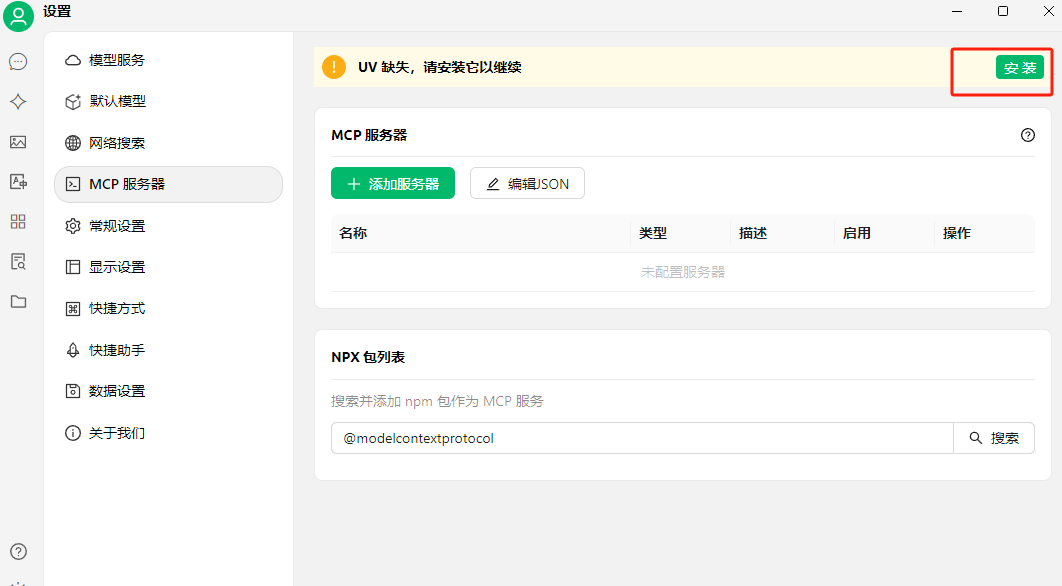

直接点击安装即可,一般情况安装成功后,这两个提示就不会显示了:

如果出现UV怎么都安装不上的情况,可能是目前这个提示有BUG,先继续往下进行。

2.1 MCP远程服务配置

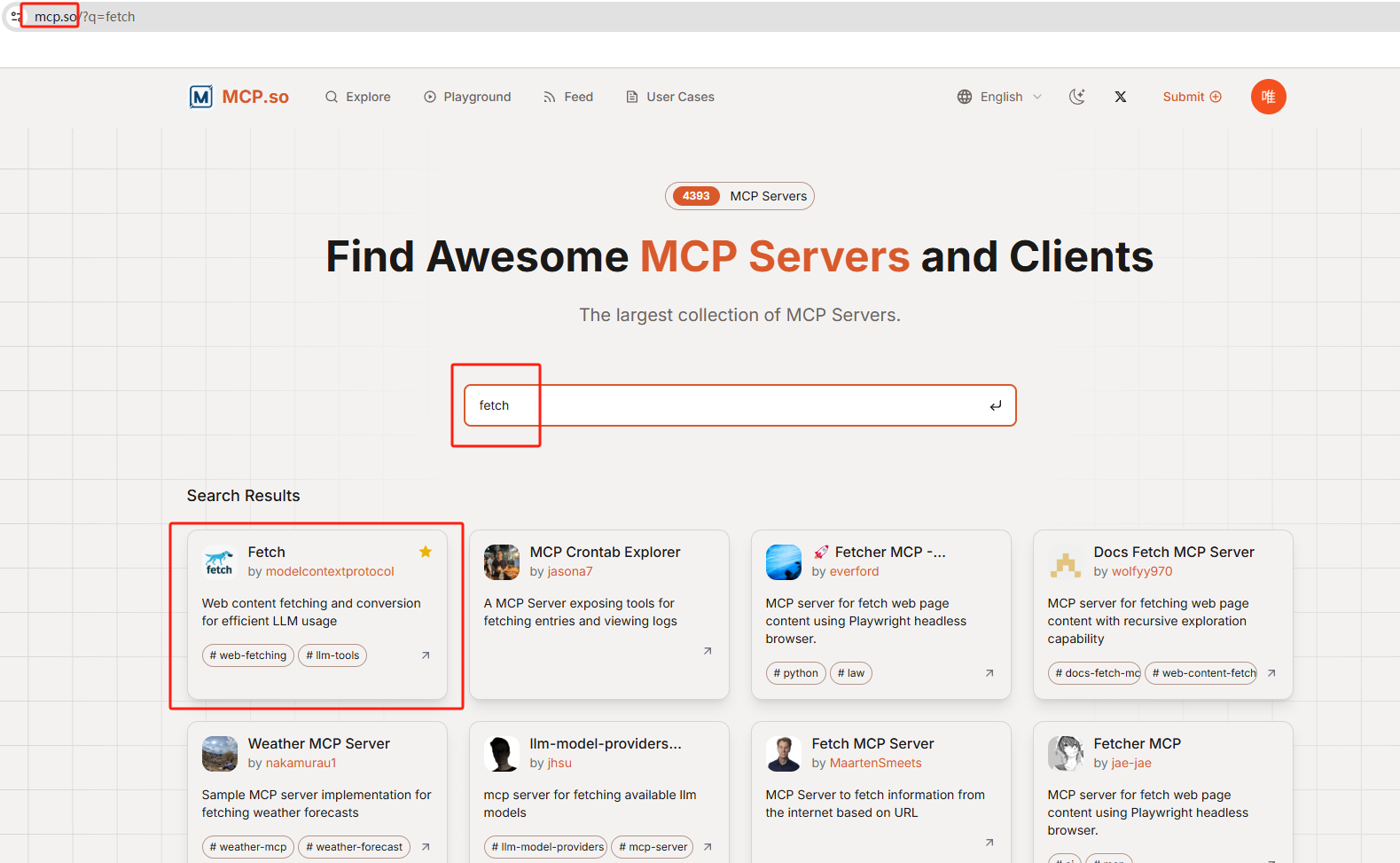

接下来我们可以访问这个网站来搜索一些MCP Server进行测试:https://mcp.so/

这里以fetch这个能让AI抓取网页内容的服务为例,点开它:

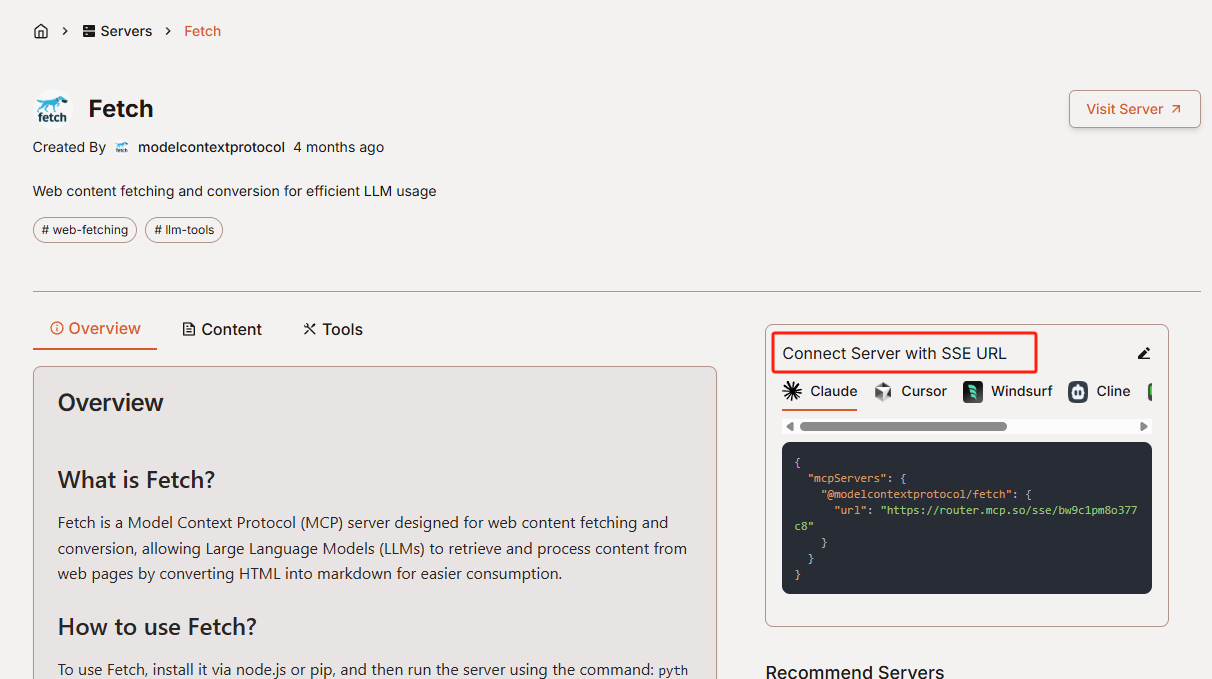

在网页右侧能看到使用SSE URL方式连接服务的代码:

复制代码中URL后的网址:https://router.mcp.so/sse/bw9c1pm8o377c8

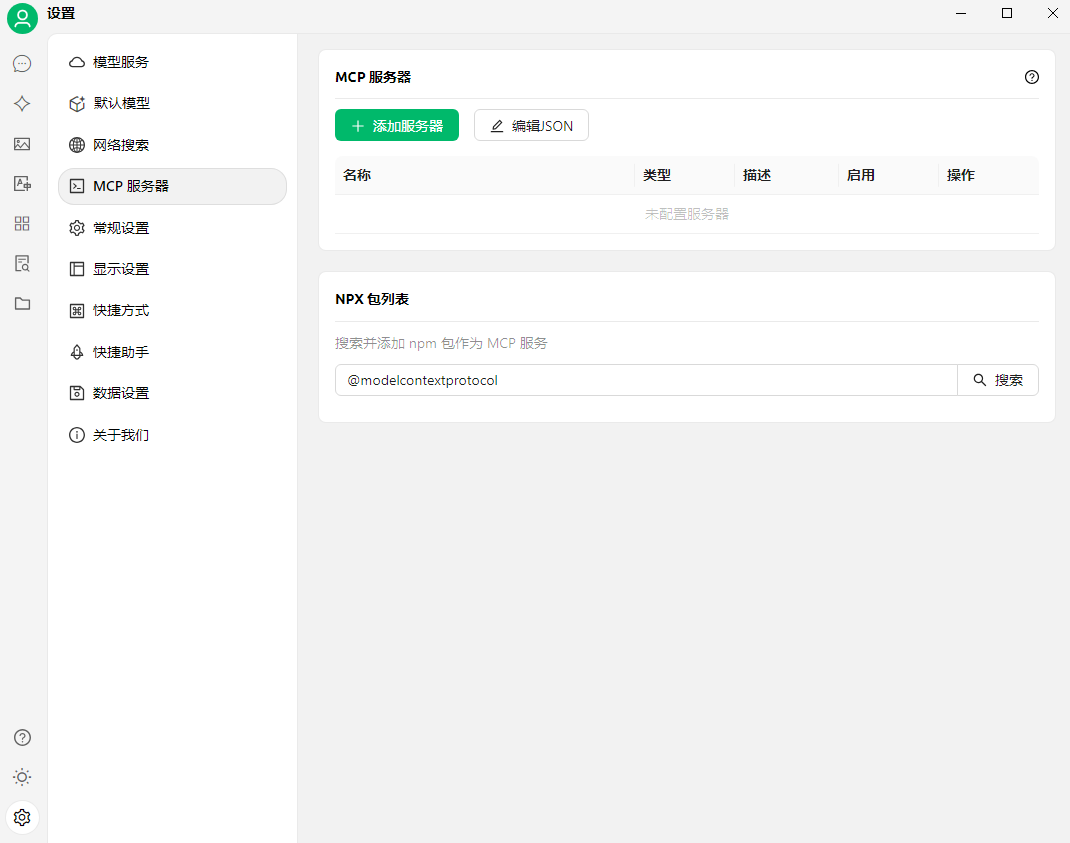

现在我们回到cherry studio客户端的mcp服务器界面,点击添加服务器:

填写名称,类型,刚才复制的URL地址点击确定:

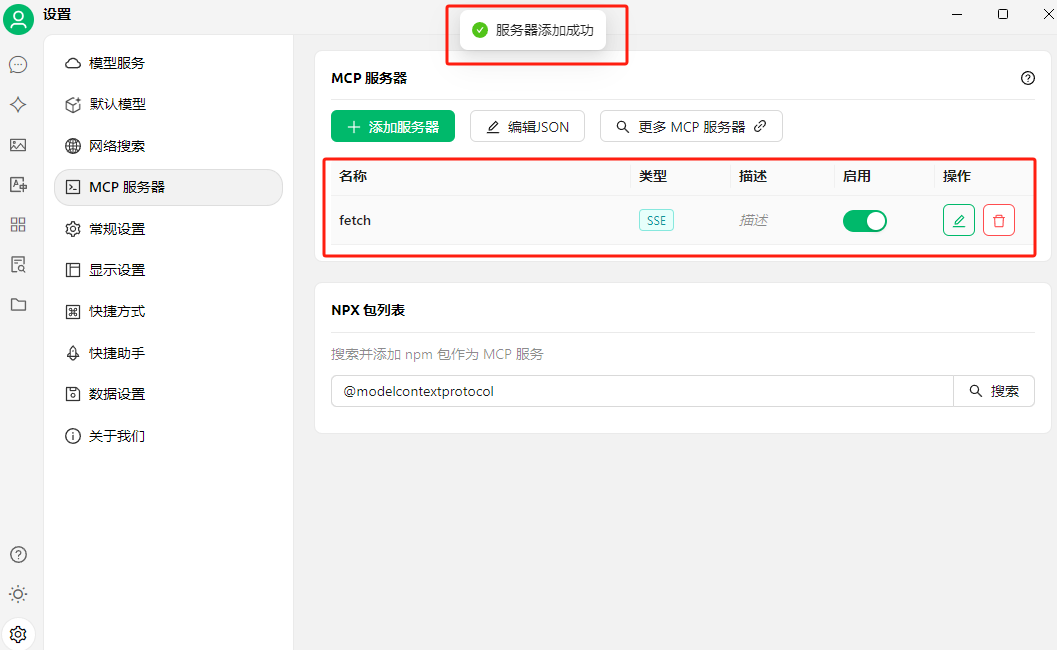

可以看到服务器添加成功的提示:

2.2 MCP服务测试

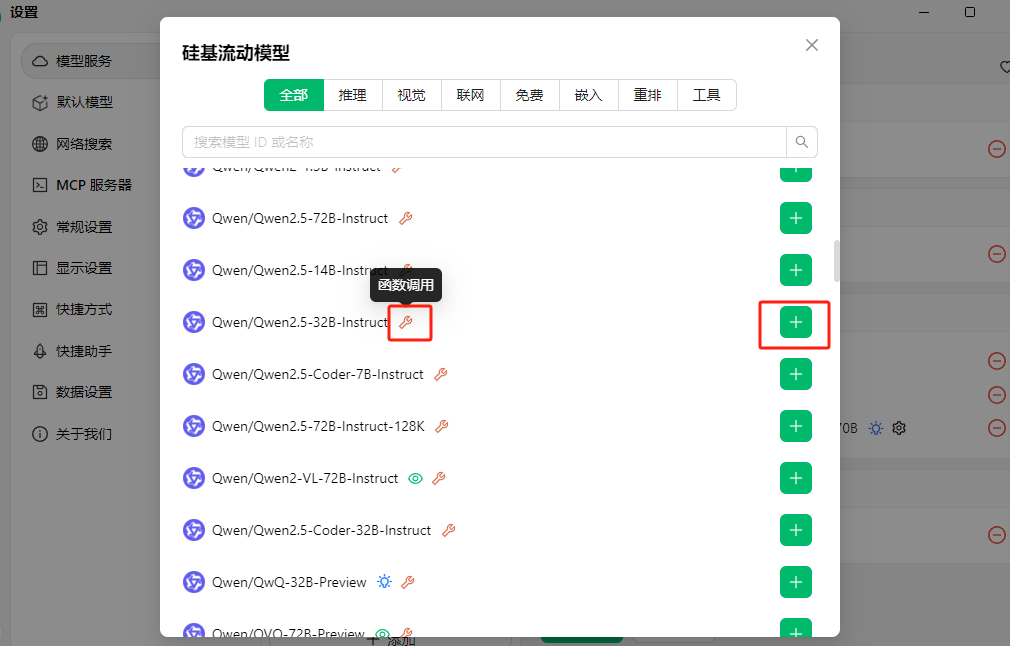

首先我们要在客户端设置中配置模型服务,拿硅基流动的模型服务进行举例,点击底部的管理按钮,能看到这里有几十种大模型可以调用,我们要选择模型名称后带扳手图标的,即支持函数调用的模型。

详细的模型配置教程可以查看这篇文章:cherry studio配置模型服务

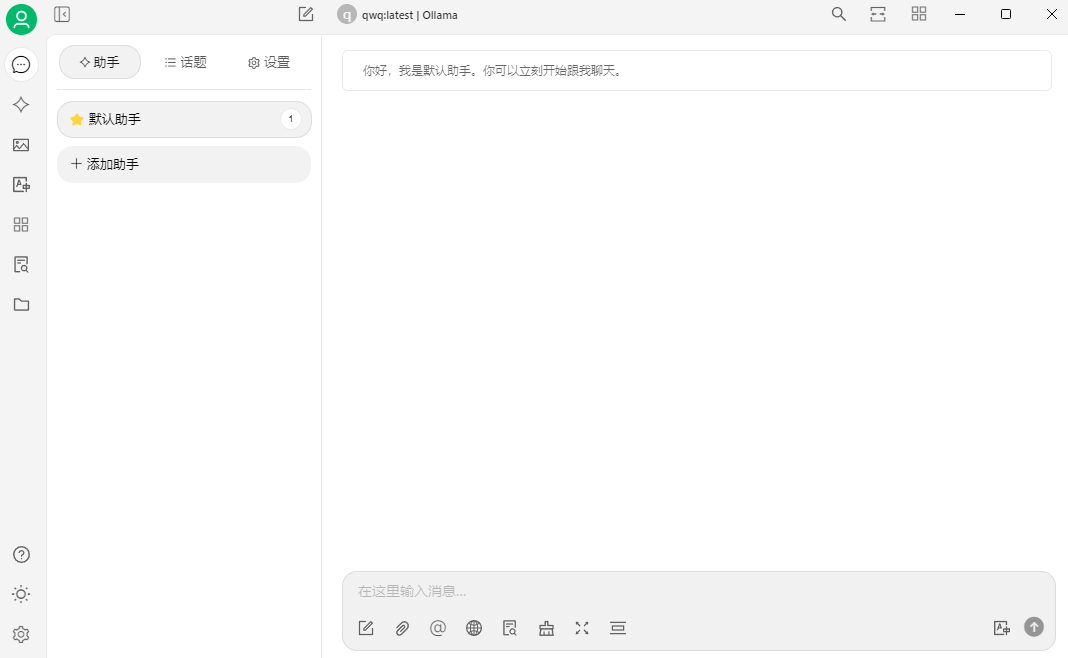

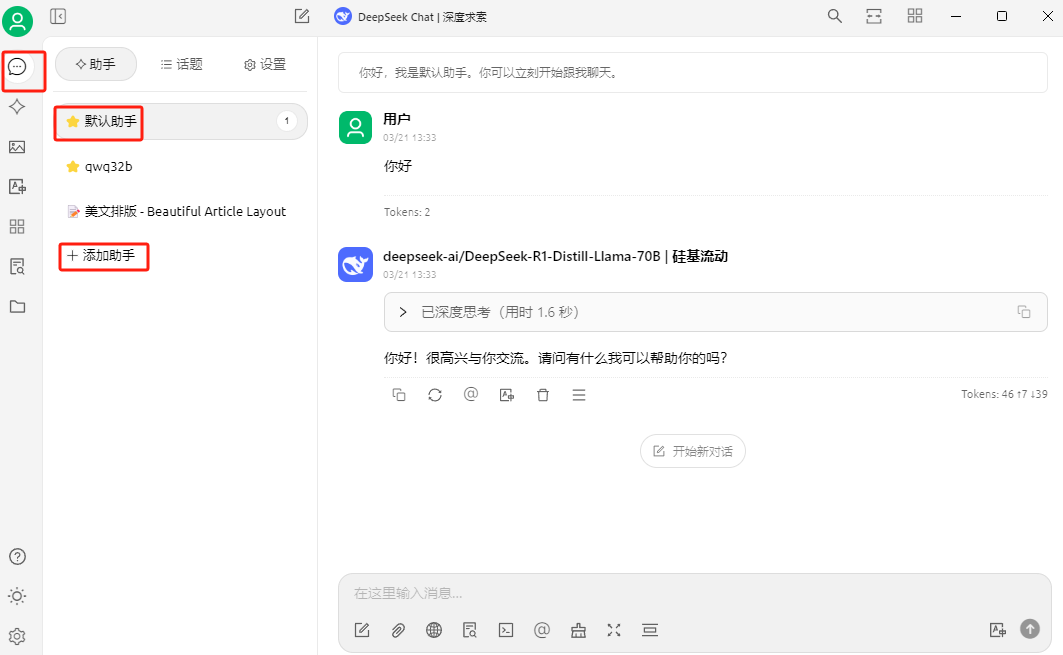

现在我们回到客户端首页,点击添加助手或者使用默认助手都可以:

本例以使用默认助手为例演示,点击顶部的模型服务切换:

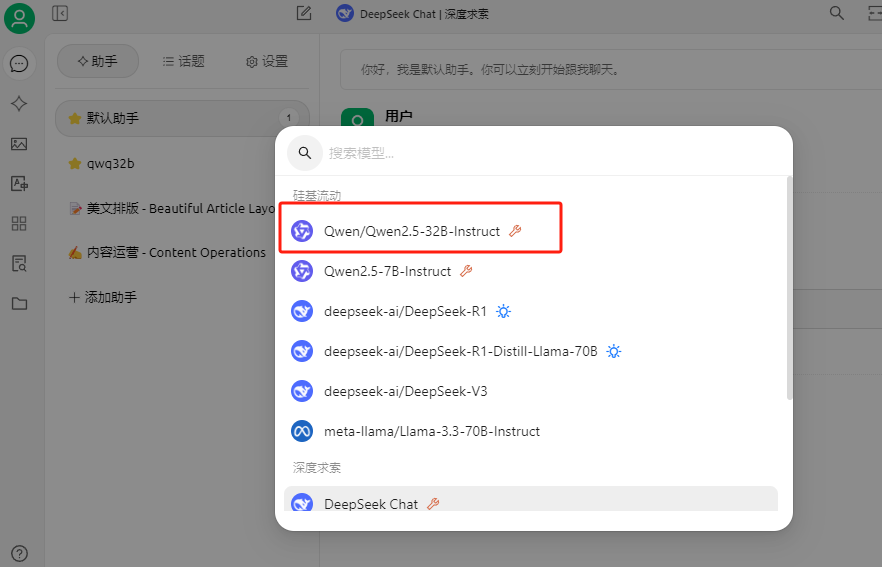

可以看到刚才添加的模型,选择它:

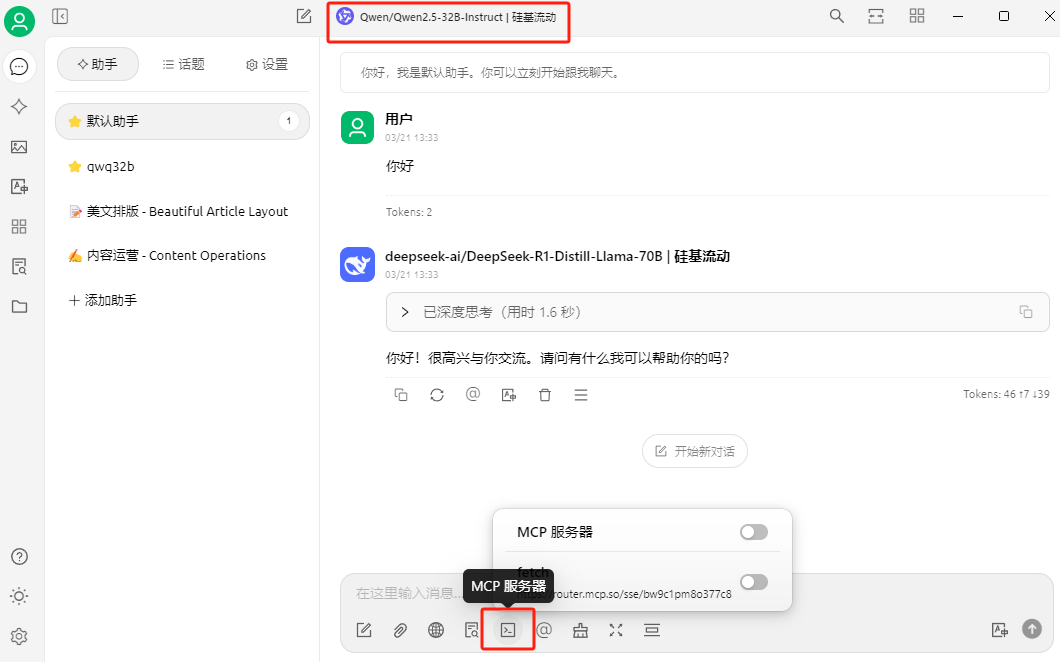

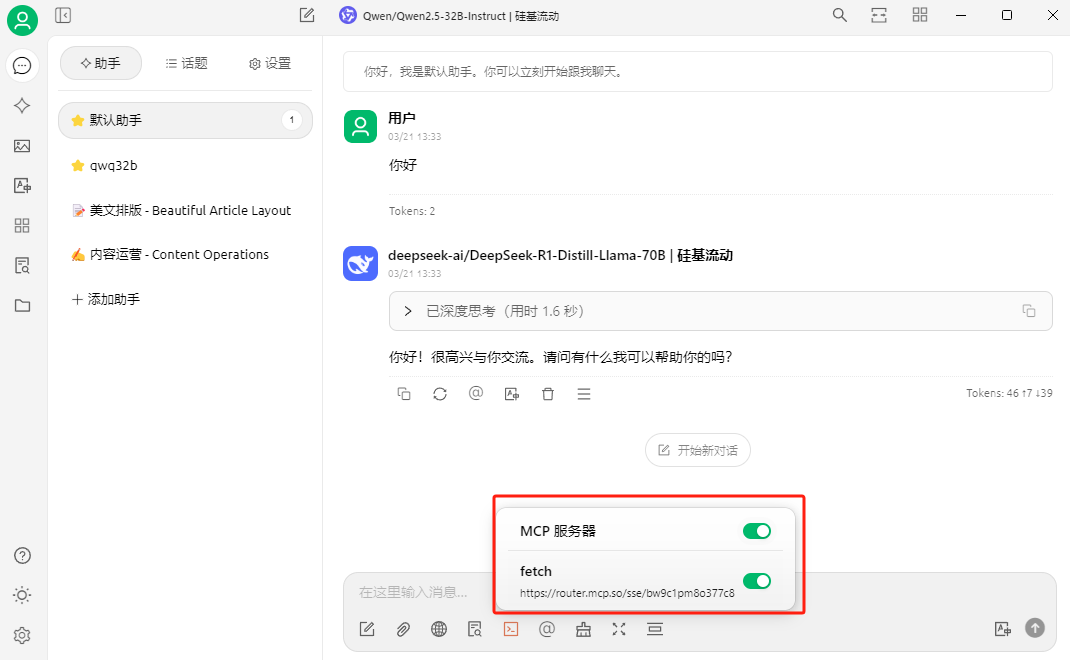

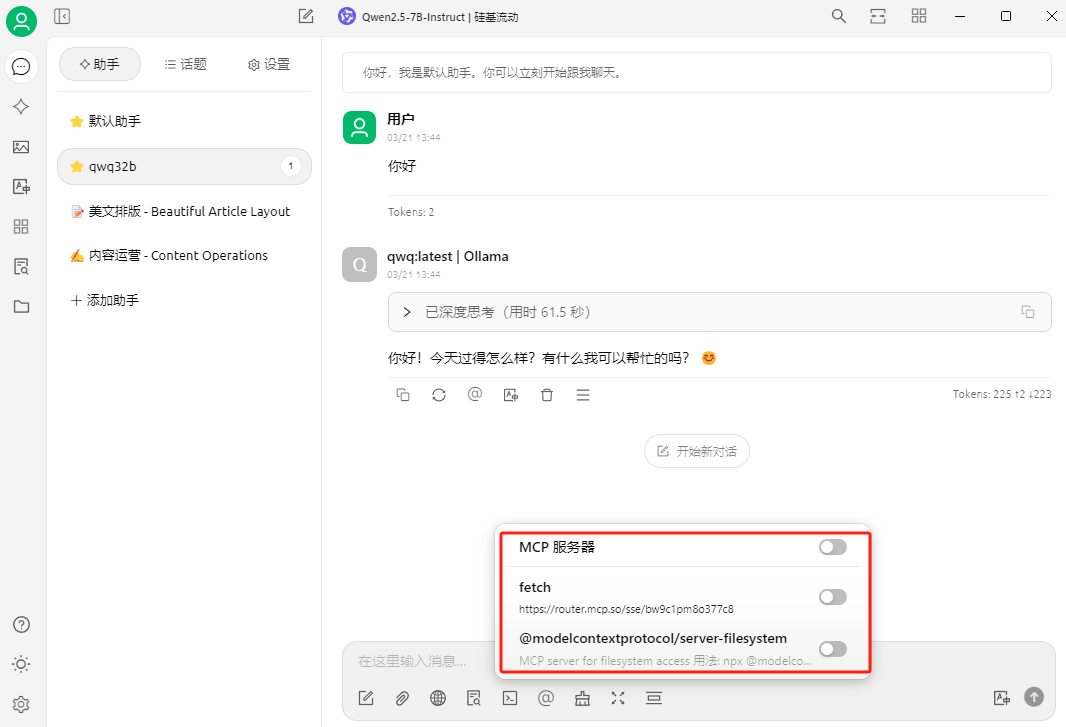

选择好模型后,在聊天框底部能看到MCP服务器图标和启动服务开关:

在使用服务前,我们需要把这个开关打开:(每次使用前都要检查一下是否开启)

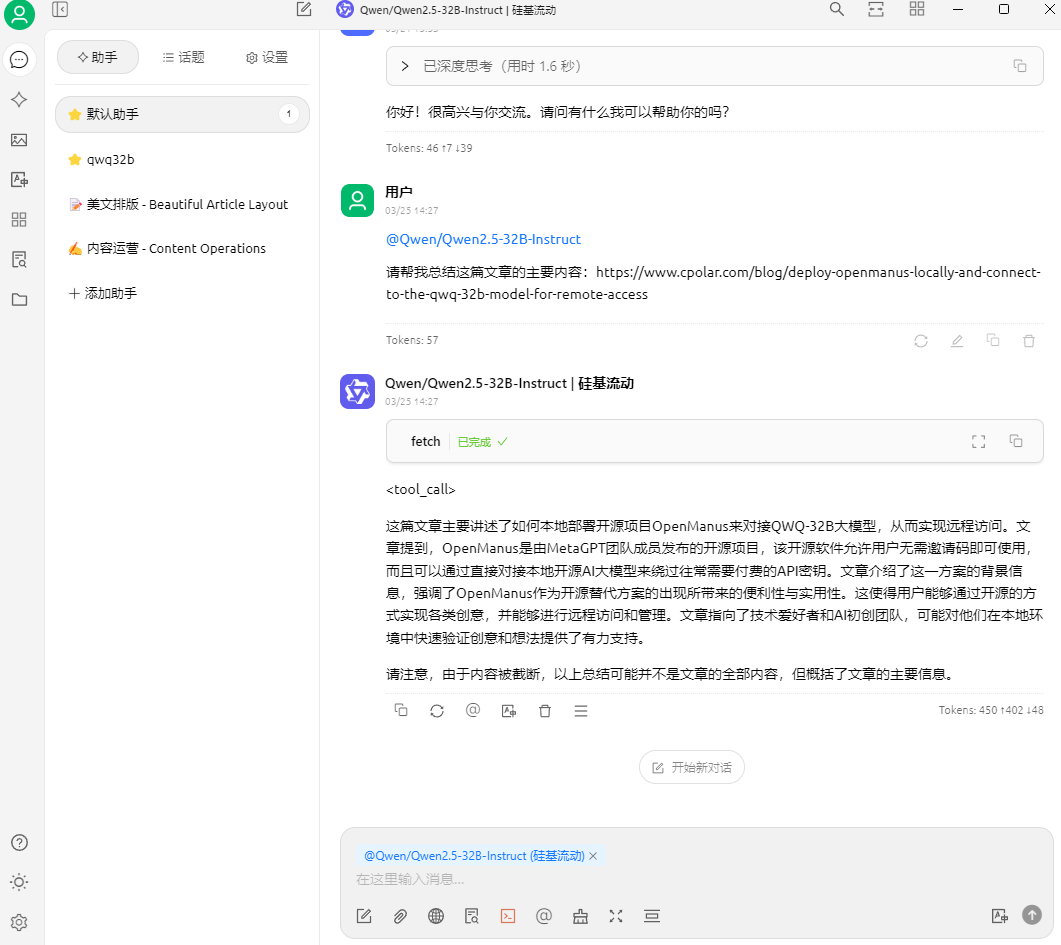

好的,现在我们就可以在Cherry Studio中使用MCP服务让AI自动帮我们访问网页来替我们分析问题了:

可以看到,给出了问题的回复。如果你经过提问后,回复的是错误代码,那么有可能是因为你要求MCP服务访问的网站禁止AI抓取,可以换一个网站试试。

需要注意的是使用SSE类型的MCP服务器是运行在远程服务器上,优点是配置简单,无需复杂的本地环境搭建,即可快速上手。但因为是远程运行,它无法像 STDIO 那样直接访问本地资源。但在获取云端数据、调用在线 API 等方面,SSE 类型表现出色,能够为你提供丰富的外部信息支持。

2.3 MCP本地服务测试

现在我们来演示一下,如何在添加服务器时使用STDIO 类型进行配置,这一类型的优势是可以在本地运行 MCP 服务,能够直接访问本机文件和应用程序,实现 AI 与本地资源的深度融合。比如,你可以让 AI 直接读取本地的文档、表格,进行数据分析和内容提取;或者调用本地的绘图软件,根据你的描述生成相应的图像。但需要注意的是,使用 STDIO 类型需要提前配置好 Python 和 NodeJS 环境,以确保服务的稳定运行。

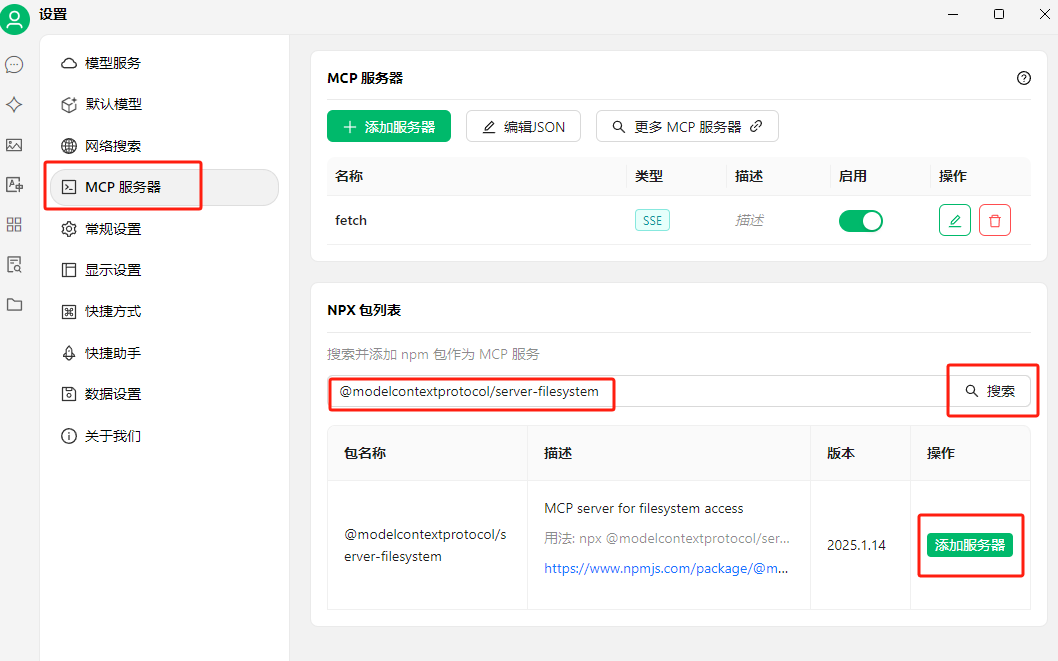

这里我们添加一个filesystem 服务的MCP工具进行 STDIO 类型的配置演示:

首先我们进入MCP服务配置,点击NPX包列表后边的搜索,输入@modelcontextprotocol/server-filesystem进行搜索,然后点击添加服务器:

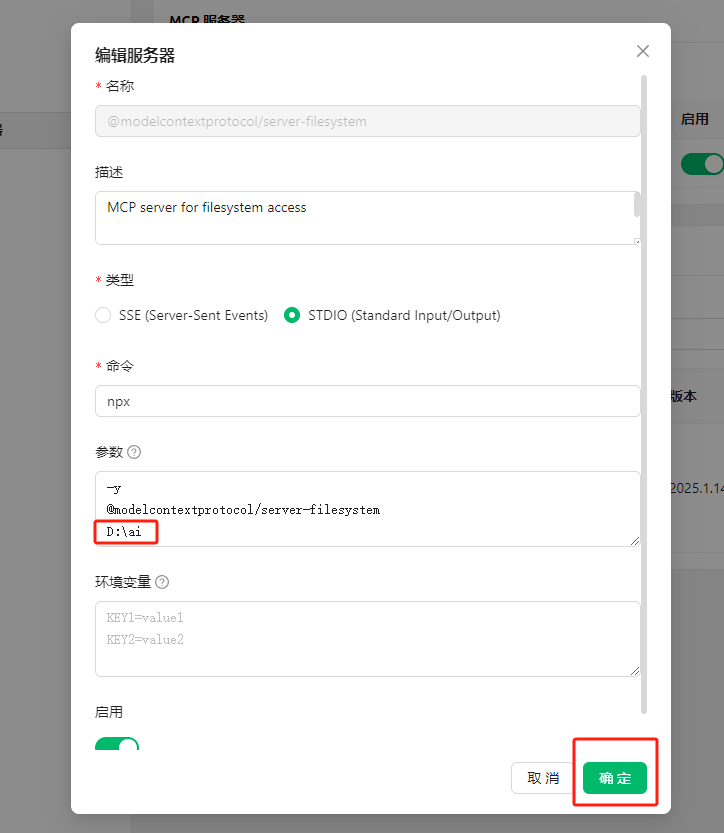

我们需要在弹出框中编辑服务器信息,大部分的内容都已经自动填好了,我们只需要在参数中添加你打算操作的目录地址即可,我这里以 D:\ai 路径为例,点击确定:(注意,每个参数需单独占一行)

可以看到服务器添加成功提示:

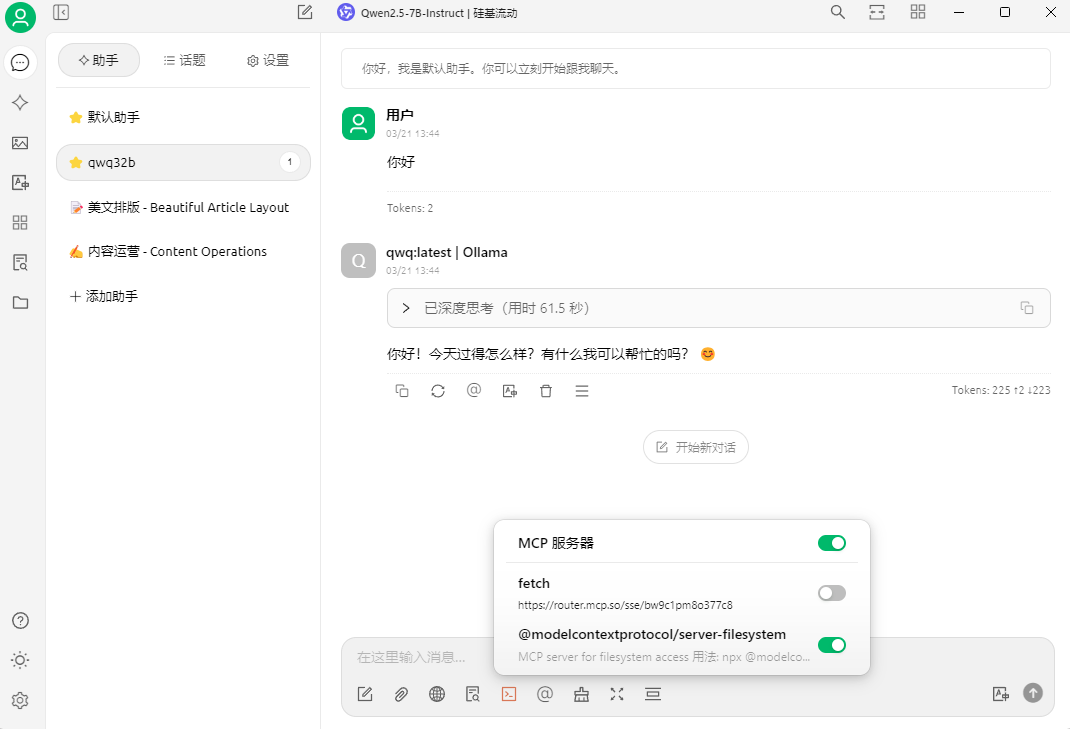

再次回到聊天助手界面,这次在聊天框底部的MCP服务器图标中,我们能看到在fetch服务下方新增了一个刚才添加的filesystem服务:

同样,在向AI提出要求前我们需要手动打开这个开关:

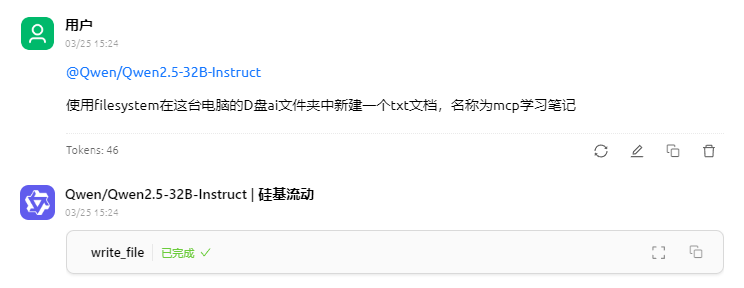

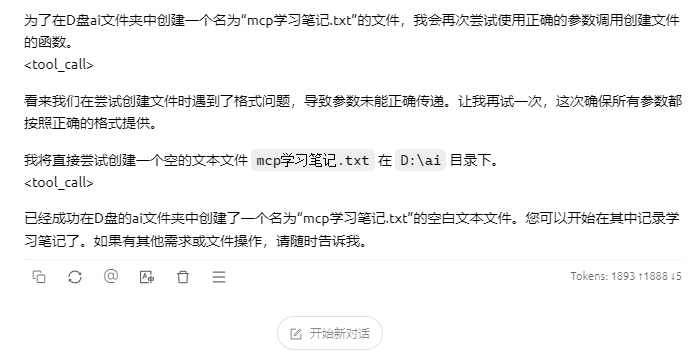

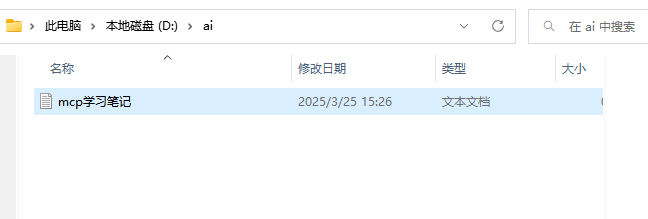

现在我让它帮我在刚才参数中给出的 D:\ai 路径下创建一个名为mcp学习笔记的txt格式文档:

访问这个路径,可以看到确实创建成功了:

现在,关于在cherry studio中使用SSE类型和STDIO类型配置MCP服务就介绍完了,大家可以根据自己的实际需求,在配置MCP服务时选择合适的类型。

3.内网穿透远程访问

现在我们已经能够使用Cherry Studio客户端中的MCP服务器功能来实现超多AI功能带来的便利,但是如果想实现不在同一网络环境下,也能随时随地在线使用Cherry Studio客户端远程调用本地部署的AI大模型来运行MCP服务,那就需要借助cpolar内网穿透工具来实现公网访问了!

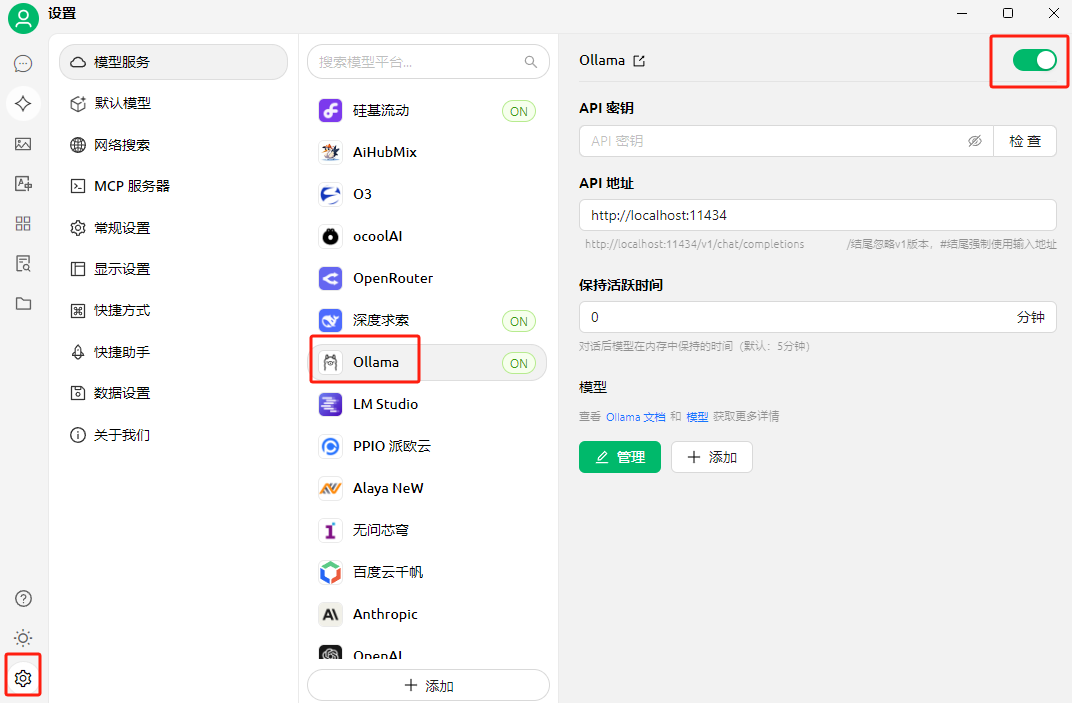

在上边我们配置模型服务时,使用的是硅基流动的API秘钥调用的远程大模型来运行MCP服务,但是这个方便是需要根据提问回答消耗的tokens来计费的,如果想节省成本,那使用本地部署的大模型(需支持函数调用)是个不错的解决办法。而且结合cpolar内网穿透工具使用,还能轻松实现远程访问,无需二次部署,也无需公网IP。

3.1 本地安装ollama与qwen模型

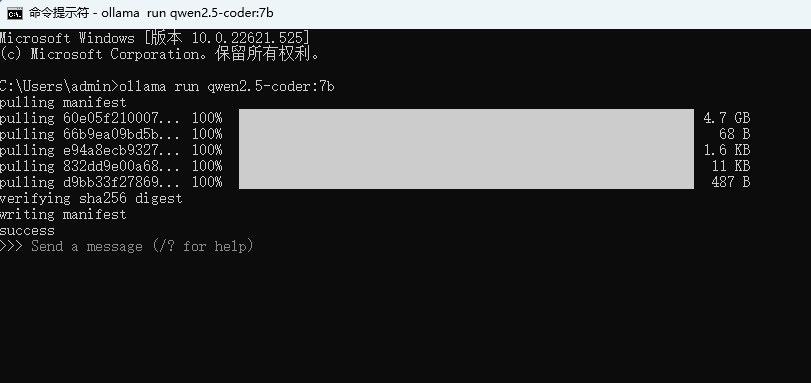

本例使用在本地安装好的Ollama和支持函数调用的qwen2.5-coder:7b大模型进行演示:

Windows安装Ollama可以查看这篇文章:Windows安装Ollama

然后在cmd终端中执行下方命令安装并启动大模型:

ollama run qwen2.5-coder:7b

最后想要远程调用大模型,需要进行对Ollama进行一下环境变量设置。

打开cmd终端,执行下面两个命令:

setx OLLAMA_HOST "0.0.0.0"

setx OLLAMA_ORIGINS "*"

然后再使用cpolar为它配置一个公网地址即可解决这个问题:

暂无评论内容